3. Brèves histoires du numérique – Il est possible, dans une certaine mesure, de retracer distinctement l’évolution des machines numériques (A) et celle de leur mise en réseau (B). Les éléments historiques proposés seront nécessairement succincts, mais ils permettront une meilleure appréhension des objets techniques complexes que le droit est appelé à encadrer. 1.

A – Les machines

4. Deux systèmes de représentation du monde — Lorsqu’une information sur le monde qui nous entoure doit être représentée — puis, éventuellement, manipulée —, deux systèmes sont concevables : l’analogique et le numérique. Selon un dictionnaire usuel, « analogique se dit d’une grandeur physique mesurée par une fonction continue ou d’un signal dont les variations sont continues » 2. Au contraire, « numérique se dit de la représentation d’informations ou de grandeurs physiques au moyen de caractères, tels que des chiffres, ou au moyen de signaux à valeurs discrètes » 3. Des exemples permettront de mieux comprendre.

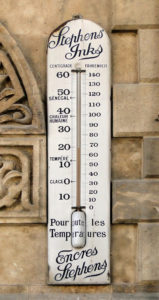

Une mesure analogique. « Thermomètre extérieur Stephen’s Inks », par Bernard Gagnon – CC BY SA 3.0

Supposons que le phénomène à retranscrire consiste dans la variation d’une température. Un thermomètre au mercure réalisera une représentation « par analogie » : le métal grimpera au sein d’un tube dans les mêmes proportions, de la même façon que la température qu’il mesure. Une grandeur physique (la hauteur de mercure) est substituée à une autre (la température). La modélisation n’aura pas de lacune : s’il y a eu passage progressif de cinq à douze degrés, le mercure aura occupé toutes les positions intermédiaires. Il aura, à un moment donné, représenté la température de 6,112 degrés, de même que celle de 9,763525 degrés : il n’y a pas d’autre limite à la finesse de la représentation que la capacité de l’observateur à la percevoir. L’information est « continue » ; elle est exhaustive. Imaginons à présent qu’un observateur scrute le thermomètre, et relève toutes les 5 secondes sa position : il en réalise un échantillonnage, en cristallisant l’information, ponctuellement, sous la forme d’un nombre – nécessairement un arrondi, dans notre exemple. L’information analogique a été numérisée, transformée en un nombre fini de symboles, qui se chargent de sens une fois interprétés, et se prêtent plus aisément à des opérations mathématiques que l’univers continu.

Une mesure numérique. Domaine public.

D’autres illustrations classiques peuvent être proposées. L’écoulement du temps peut être représenté analogiquement par une clepsydre : l’information matérialisée par le passage du fluide sera continue. Si ce sont les vibrations d’un quartz stimulé électriquement qui sont utilisées pour fonder la régularité d’une horloge, il existe ensuite deux manières d’en tirer parti. Une trotteuse procédant à des rotations constantes autour d’un axe constitue un procédé analogique, tandis qu’un affichage numérique sera le produit d’un échantillonnage auquel on assignera une certaine précision – à la seconde, au milliardième de seconde. De même, la fréquence d’une note de musique ou l’intensité d’un son peuvent être converties en un courant électrique : il s’agit toujours de remplacer un phénomène physique par un autre, par analogie. On pourra alors représenter le résultat sous forme d’une courbe, parfaitement continue, sur un écran. Passer à une représentation numérique impliquera de changer la courbe en un nuage de points.

5. Calculateurs numériques et analogiques – Le lecteur contemporain, conscient du triomphe final du numérique sur l’analogique, pourrait croire que les deux techniques de représentation ont succédé l’une à l’autre au cours du temps, l’une étant moderne et l’autre archaïque. Ce serait une erreur : elles ont très longuement cohabité.

Elles sont aussi anciennes l’une que l’autre. Si l’on considère les machines à calculs les plus rudimentaires, le boulier appartient à la famille numérique : la réalité y est représentée par un ensemble fini de symboles, les boules. En revanche, le mécanisme d’Anticythère, daté du IIe siècle avant Jésus-Christ, était constitué d’un ensemble d’engrenages qui, en pivotant, proposaient une modélisation en continu de la course du soleil, de la lune et d’autres astres 4.

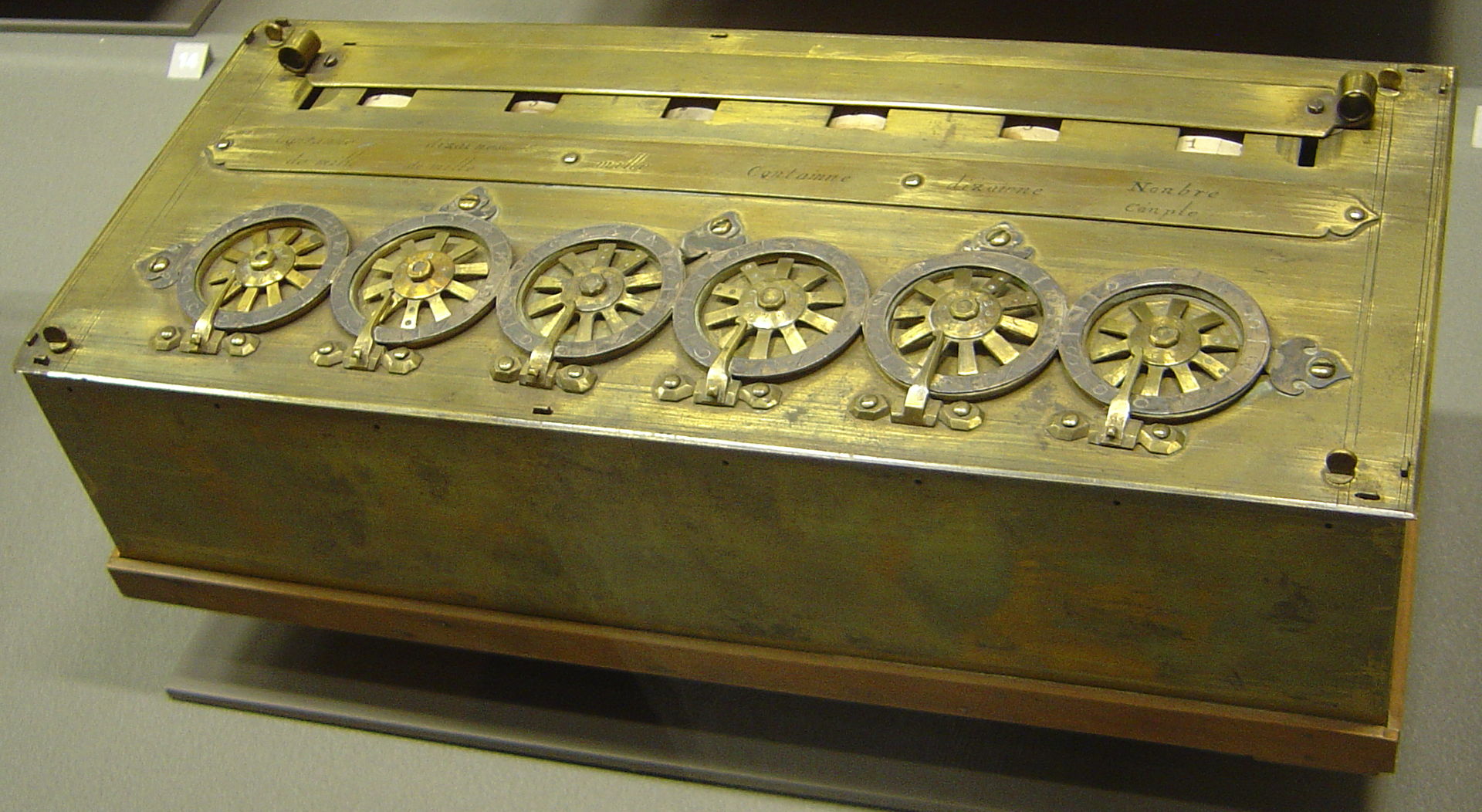

Avançons jusqu’au XVIIe siècle, et constatons que des calculatrices bien plus perfectionnées sont apparues dans l’un et l’autre groupe. La Pascaline, machine à additionner et soustraire les nombres jusqu’à six chiffres, imaginée par Blaise Pascal, appartient au monde numérique 5. Presque au même moment apparaît la règle à calcul, instrument constitué de plusieurs échelles graduées coulissantes permettant non seulement de réaliser les opérations basiques, mais encore de calculer des racines carrées, cubiques, ou encore des logarithmes. Les mouvements des bandes les unes par rapport aux autres sont continus, et sont donc à classer dans l’univers analogique, même si au terme du processus l’œil de l’utilisateur va rechercher la graduation la plus proche du résultat et procéder à un arrondi – une sorte de numérisation par échantillonnage. L’instrument a été utilisé par les ingénieurs du monde entier jusque dans les années 1970 6.

Par "Epic Teaching of the History", épisode 17

La Pascaline du musée des arts et métiers du CNAM - Par David Monniaux, CC BY SA 2.0

L’analogique, de manière générale, n’est pas une technique de calcul plus faible ou plus lente que le numérique. Au contraire, face à des problèmes d’égale complexité, la résolution analogique a longtemps été beaucoup plus rapide. En effet, une fois qu’a été construit ou mis en place un système de représentation analogue au phénomène physique que l’on entend mesurer, il n’y a plus qu’à le faire fonctionner avec certaines valeurs d’entrée et à constater les valeurs de sortie, sans qu’il soit nécessaire d’analyser les détails du fonctionnement intermédiaire. Par exemple, pour connaître les caractéristiques aérodynamiques d’un appareil volant, il suffit d’en bâtir une maquette à petite échelle et de le placer en soufflerie : sans même qu’il soit nécessaire de modéliser, ni même de comprendre totalement les dynamiques à l’œuvre, il sera possible d’observer la réaction. À l’inverse, faire fonctionner une simulation, appelée par la pratique « soufflerie numérique », rend nécessaire la modélisation mathématique exhaustive du système, sa mise en équations complète. Il faut ensuite fournir les valeurs d’entrées à une machine numérique, qui procédera aux lourds calculs nécessaires à la restitution de valeurs de sortie.

Ainsi, les calculateurs analogiques constituaient un choix judicieux lorsqu’il fallait représenter une situation complexe, mais dont les grandes lignes étaient prévisibles à l’avance, et qu’il était nécessaire d’obtenir un résultat très rapide. En matière de balistique militaire, « l’ordinateur analogique » Dumaresq a longtemps été employé pour guider l’artillerie en situation de combat naval 7. D’abord mécaniques, les ordinateurs analogiques sont peu à peu devenus électroniques, les ressorts et autres pistons étant remplacés par des inducteurs ou des résistances obéissant aux mêmes équations.

Malgré ses mérites, l’analogique a tout de même fini par être supplanté par le numérique en tant que machine à calcul.

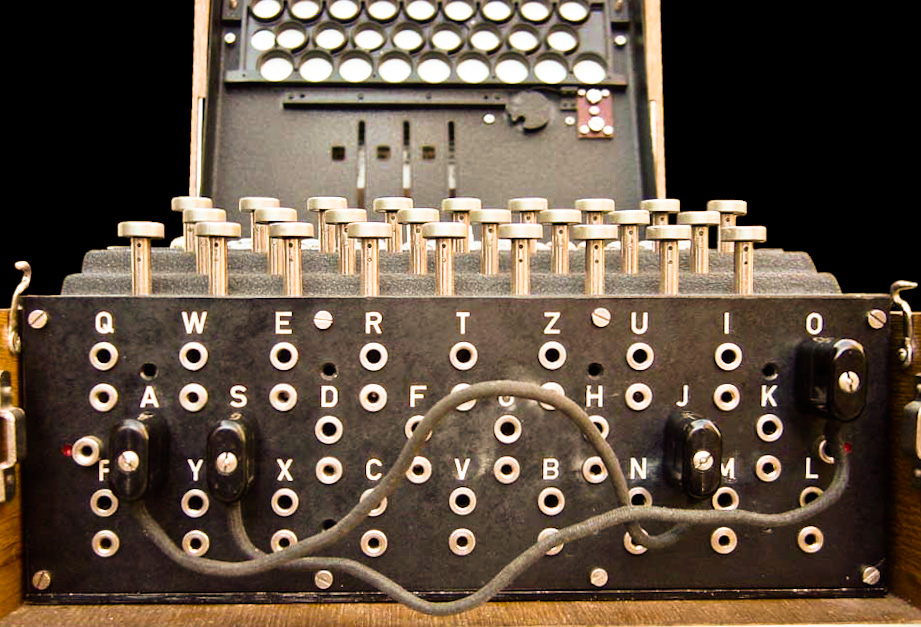

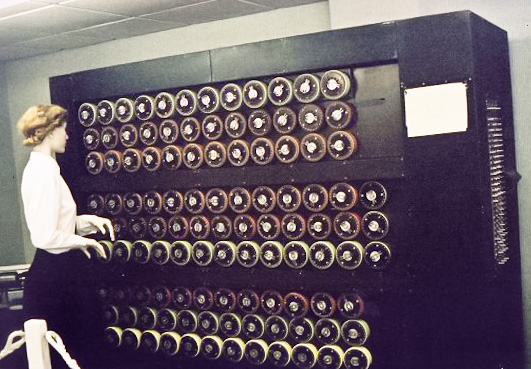

6. Turing et le triomphe du numérique – Dès 1834, le mathématicien anglais Charles Babbage imagine une machine que beaucoup considèrent comme l’ancêtre de l’ordinateur. Mais c’est au cours de la Deuxième Guerre mondiale que l’intérêt pour ce type de machine, et, corrélativement, les moyens financiers alloués à leur fabrication va véritablement exploser. Le conflit fut en effet le théâtre d’un affrontement entre deux machines numériques : l’Enigma nazie et la « bombe » de l’anglais Turing

Alan Turing. Domaine public.

8. Les armées allemandes utilisaient des communications chiffrées, c’est-à-dire incompréhensibles pour qui ne possédait pas un code secret. Il s’agissait d’un chiffrement par décalage, c’est-à-dire que chaque lettre du message « en clair » était déplacée d’un ou plusieurs rangs dans l’alphabet. Jules César utilisait déjà cette technique, mais il appliquait un décalage uniforme sur l’ensemble du message (par exemple, trois rangs vers le Z), terriblement rudimentaire. Enigma avait porté ce procédé à un très haut degré de sophistication.

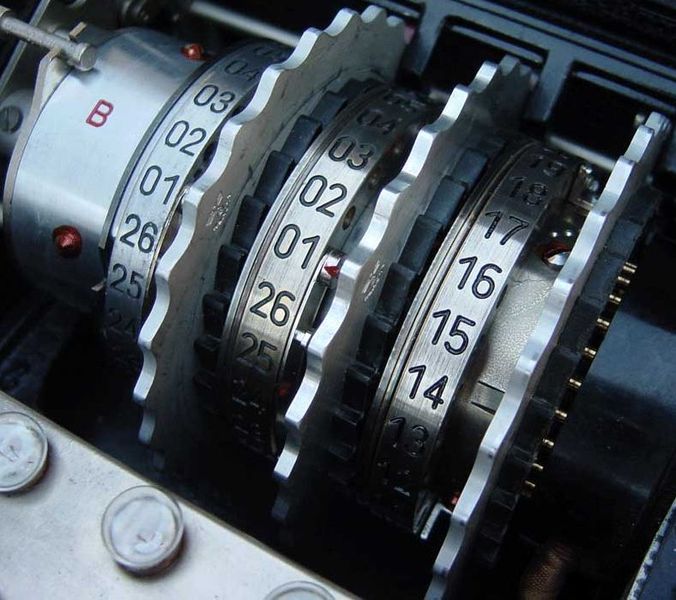

Son utilisation était en apparence fort simple : l’opérateur saisissait son message « en clair » sur le clavier de la machine. Au fur et à mesure, des diodes s’allumaient pour indiquer quelles étaient les lettres constituant la version chiffrée. Ce résultat était obtenu par la circulation d’un courant électrique partant de la touche pressée et parvenant à la diode à allumer. L’objectif était de rendre ce parcours aussi complexe et difficile à prévoir que possible. Pour y parvenir, les ingénieurs allemands faisaient notamment transiter les électrons par des « rotors », des disques pivotants munis de contacteurs électriques 9. Appliquer la clé de chiffrement — qui changeait tous les jours — consistait à placer chacun des rotors dans une certaine position avant d’entamer la saisie ou le déchiffrement du message. De surcroît, les rotors se déplaçaient au fur et à mesure de la frappe, l’un d’entre eux pivotant même à chaque pression d’une touche.

C’était donc une énigme numérique qui était posée : un ensemble fini de symboles (les lettres de l’alphabet) subissait une transformation mathématique (un décalage d’un ou plusieurs rangs). Il fallut une autre machine pour en venir à bout. Elle fut conçue à Londres, par une équipe de scientifiques dirigée par Alan Turing. Sa fonction était de tester à une vitesse effrénée les différents réglages possibles d’Enigma, en les appliquant aux messages chiffrés interceptés par les Alliés.

Mais si Turing est souvent considéré comme le père de l’informatique moderne, c’est peut-être davantage encore en raison de sa description du concept abstrait connu sous le nom de machine de Turing 10. Il définit les contours théoriques d’une machine capable d’exécuter des calculs de toutes sortes lorsqu’elle est mise en œuvre à l’aide de langages de programmation adéquats. Alors que le calculateur analogique est spécialisé, et doit être reconstruit ou au moins reconfiguré à chaque fois qu’il doit résoudre un problème différent, l’ordinateur numérique est capable, sans subir aucune modification physique, de s’attaquer à une infinité de problèmes et de manipulations mathématiques de l’information. Dans l’après-Deuxième Guerre mondiale, c’était au prix d’une certaine lenteur dans l’exécution, mais l’augmentation exponentielle des puissances de calcul a fait peu à peu disparaître ce dernier inconvénient.

"Modern model of Charles Babbage's Analytical Engine displayed at the Science Museum, London" par Macin Wichary - CC BY 2.0

"Enigma rotor" par Bob Lord - CC BY SA 3.0

Enigma machine plugboard par Bob Lord - CC BY SA 3.0.

"Mockup of a bombe machine at Bletchley Park" par Sarah Hartwell - CC BY SA 3.0

Le numérique a également cet avantage sur l’analogique qu’il permet la reproduction à plusieurs reprises d’un ensemble de données sans perte de qualité, tandis que réaliser des copies de copies analogiques entraîne un affaiblissement progressif du signal, jusqu’à le rendre inexploitable 11.

7. L’informatique moderne – L’histoire récente du calcul numérique ne sera esquissée qu’en quelques mots. En 1962, la place des ordinateurs dans les mondes de la recherche et des très grandes entreprises justifie qu’un mot nouveau soit inventé pour désigner les activités qui lui sont relatives. Deux Français proposent de fusionner « information » et « automatique » pour donner « informatique » 12. Aux USA, « informatics » aurait pu s’imposer de même, s’il n’avait pas été déposé par une société de développement de logiciels qui en interdit ensuite l’usage à tout autre 13.

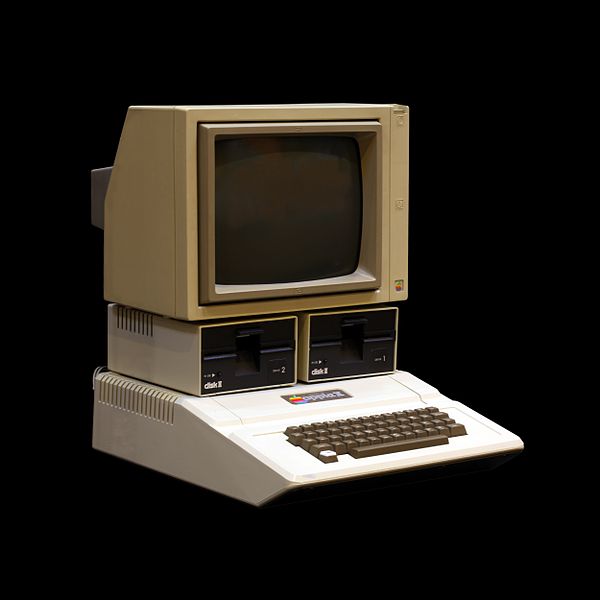

Apple II, musée Bolo de l’EPFL par Rama – CC BY SA 2.0

Lorsqu’il s’agit d’illustrer le développement de l’informatique personnelle, plusieurs appareils et dates peuvent être proposés. Nous retiendrons ici l’Apple II de 1977, en ce qu’il constituait la première machine vendue directement fonctionnelle – auparavant, les composants devaient être achetés séparément et assemblés, ce qui réservait l’utilisation des machines à un public éclairé 14. Mais un matériel informatique bien conçu n’est rien sans logiciel lui conférant une utilité pratique : aussi faut-il mentionner le premier grand best-seller de l’industrie du secteur, sorti sur la machine d’Apple : VisiCalc, un tableur qui permit notamment aux petites entreprises de gérer avec une efficacité inédite leurs stocks ou leur comptabilité. De ce programme, on a pu écrire : « C’est une formidable accélération donnée à l’industrie micro-informatique. Tout un écosystème économique se met en place incluant éditeurs de logiciels, développeurs indépendants, boutiques de ventes grand public, magazines d’informatique… » 15.

Il n’est guère possible d’aller plus avant dans l’histoire de l’informatique sans se préoccuper de la mise en réseau des machines.

B – Les réseaux

8. Première description théorique d’Internet – Chacun connaît le rôle joué, durant la Guerre froide, par la théorie de la mutually assured destruction (MAD), la destruction mutuelle assurée. Une attaque nucléaire américaine ou soviétique devait mener à une série de tirs de rétorsion entraînant la destruction des deux belligérants, en même temps que celle du reste de la planète. Si l’attaquant potentiel avait la certitude d’être puni en retour et de tout perdre, le bouton ne serait jamais pressé.

Un ordinateur militaire simule plusieurs scénarios de guerre nucléaire. Extrait de War Games, 1983, dir. John Badham.

Mais l’ensemble de cette doctrine était menacé par la faiblesse des réseaux de communication de l’époque :

A nuclear detonation in the ionosphere would cripple FM radio communications for hours, and a limited number of nuclear strikes on the ground could knock out AT&T’s highly centralized national telephone network. (…) A key tenet of MAD was that the fear of retaliation would prevent either Cold War party from launching a first strike. This logic failed if a retaliatory strike was impossible because one’s communications infrastructure was disrupted by the enemy’s first strike 16.

C’est pour répondre à ces préoccupations qu’un chercheur du think tank américain Research and Development (RAND), Paul Baran, jeta en 1960 les bases théoriques d’un système préfigurant de manière frappante le réseau Internet 17. Plutôt que de transiter par un central, les informations sauteraient de nœud en nœud au sein d’un réseau décentralisé – tout en conservant la mémoire de la longueur du trajet parcouru afin que le chemin le plus court soit identifié et utilisé dès que possible 18. La destruction de nœuds entraînerait simplement la redirection des paquets par le meilleur chemin ensuite disponible.

Packet, routers, and reliability | Internet 101 | Computer Science | Khan Academy

Pour parvenir à ce résultat, Baran proposait une alliance de deux disciplines, l’informatique et les télécommunications, qui semble constituer une évidence pour le lecteur contemporain, alors qu’elles étaient à l’époque tout à fait étrangères l’une à l’autre 19. Les ordinateurs permettaient d’apporter au réseau intelligence et réactivité.

Ces réflexions restèrent dans l’immédiat cantonnées à la sphère de la théorie militaire : les infrastructures imaginées n’existaient pas encore, et la compagnie de téléphone AT&T s’opposa activement à l’expérimentation d’un tel système 20.

9. Première mise en œuvre – De concept abstrait, le réseau décentralisé d’ordinateurs se muera en réalité concrète au sein d’une structure appelée Advanced Research Projects Agency (ARPA), agence civile au service du Pentagone, destinée à mutualiser les meilleurs talents des différentes armes (Army, Navy, Air Force) dans le domaine scientifique, sans leur assigner d’objectifs de court-terme susceptibles de brider leur créativité 21. Un projet d’amélioration des infrastructures de communication militaires vit le jour en 1967. L’influence éventuelle des travaux précurseurs de Baran n’est pas tout à fait claire ; toujours est-il qu’une direction similaire fut suivie : il s’agissait de bâtir un réseau capable de transférer des données découpées en petits paquets, de nœud en nœud, jusqu’à leur destination finale 22. Dès l’année suivante, un financement fut accordé pour la construction d’un réseau à quatre nœuds reliant les universités de Stanford, Santa Barbara, Los Angeles et de l’Utah 23. C’est en effet dans les établissements d’enseignement supérieur et de recherche que se trouvaient les principales ressources informatiques civiles de l’époque. Ce lien entre Internet et le monde académique américain restera très fort par la suite. La première communication effective eut lieu le 29 octobre 1969. Elle a pu être relatée ainsi :

The plan was unprecedented: Kleinrock, a pioneering computer science professor at UCLA, and his small group of graduate students hoped to log onto the Stanford computer and try to send it some data. They would start by typing « login, » and seeing if the letters appeared on the far-off monitor.

« We set up a telephone connection between us and the guys at SRI…, » Kleinrock … said in an interview: « We typed the L and we asked on the phone,

« Do you see the L ? »

« Yes, we see the L, » came the response.

« We typed the O, and we asked, « Do you see the O ? »

« Yes, we see the O. »

« Then we typed the G, and the system crashed »…

Yet a revolution had begun » 24.

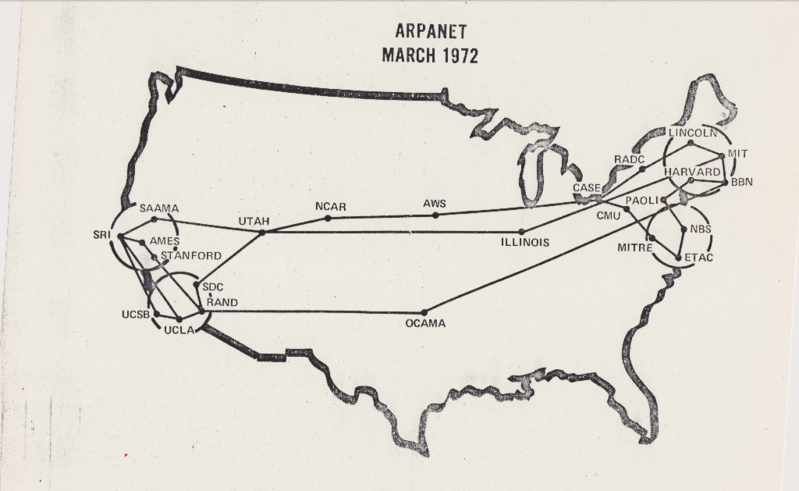

« The map of ARPANET in March 1972 », UCLA et BBN – CC BY SA 4.0

En 1971, le réseau s’était étendu à quinze nœuds. L’ARPANET, le réseau de l’ARPA, préfigurait à l’évidence l’arrivée d’Internet, mais ne se confond pas avec lui. Il s’agissait en effet d’un réseau homogène, conçu et mis en œuvre de bout en bout par les mêmes équipes, tandis qu’Internet est une curieuse créature de bric et de broc.

10. Bâtir Babel : l’invention des protocoles de communication – Permettre un dialogue non seulement entre ordinateurs au sein d’un même réseau, mais aussi entre réseaux distincts, inventer une langue commune à tous, était la condition de l’apparition d’Internet. La tâche fut initialement confiée à un simple groupe de graduate students disséminé dans les diverses universités financées par l’ARPA. Les techniques et l’ambiance de travail adoptés méritent d’être évoqués en quelques mots, car ils sont décrits par les historiens du réseau comme « ayant donné le ton pour le développement de la future culture Internet » 25. L’étudiant ayant initié la discussion ne pouvant se prévaloir d’aucun titre ni d’aucune position hiérarchique, il intitula modestement son message « request for comments » (RFC), soit « appel à commentaires » 26. Les RFC sont devenus par la suite les documents officiels décrivant le fonctionnement technique d’Internet 27. Leur élaboration obéit à un processus dont la philosophie générale n’a pas varié depuis : « rough consensus and running code – that means we don’t really vote exactly, we just try to assess rough consensus among the group trying to agree on proposed standard » 28. À la lumière de ces éléments, le mode de fonctionnement d’une institution contemporaine comme l’ICANN, abordé plus loin dans l’étude, se comprendra plus aisément 29. Les premiers travaux du groupe donnèrent naissance au Network Control Protocol (NCP), qui permettait aux machines de dialoguer au sein de l’ARPANET.

Restait à connecter les réseaux entre eux : à côté du réseau filiaire ARPANET, existaient en effet au milieu des années 70 le réseau radio PRNET, ainsi que le réseau satellite SATNET 30. En 1974, une équipe dirigée par Vinton Cerf mit au point cette langue commune qui marquerait la naissance du réseau des réseaux : le Transmission Control Protocol (TCP). Le RFC destiné à décrire cette norme technique fait apparaître, dans son titre, un mot nouveau, abréviation d’inter-networking : Internet 31. Un autre protocole fut conçu, l’Internet Protocol (IP), dont l’objectif n’est pas de permettre la communication entre réseaux, mais de fournir à chaque machine connectée une adresse unique permettant de l’identifier comme émetteur et receveur d’informations 32. Son importance était également fondamentale.

L’ensemble appelé TCP/IP est toujours à la base du fonctionnement d’Internet, et a été mis gratuitement à la disposition de tous par ses inventeurs.

11. Du réseau aux usages – Un des principes fondateurs d’Internet veut que l’infrastructure de communications et les protocoles TCP/IP transportent les paquets de données de manière aveugle, sans aucun égard pour leur contenu exact. Nous y reviendrons longuement, notamment en abordant le principe de « neutralité du réseau », qui fait actuellement l’objet de vifs débats 33. Le mot « Internet » désigne donc, dans un sens strict, uniquement un véhicule de l’information, mais non les finalités de ce transport. Certains usages ont été inventés au temps d’ARPANET ; d’autres sont plus récents ; n’importe qui peut en imaginer de nouveaux à chaque jour qui passe. Ils prennent la forme de protocoles supplémentaires, relevant de la « couche applications », qui fonctionnent au-dessus des protocoles de la « couche communication ».

Une des premières possibilités d’utilisation d’ARPANET avait consisté à utiliser un autre terminal informatique à distance. Soit un chercheur qui se trouve dans une université A, mais qui souhaiterait utiliser la puissance de calcul bien supérieure disponible dans l’université B. Il pouvait utiliser le réseau pour s’identifier sur la machine de B et en prendre le contrôle depuis les locaux de A 34.

Très rapidement (dès 1971), un protocole de transfert de fichiers (File Transfert Protocol ou FTP) est mis au point, qui permet notamment de rapatrier un fichier présent sur l’ordinateur B vers l’ordinateur A sans avoir besoin de s’identifier sur cette machine distante 35.

La messagerie électronique, ou email, est inventée seulement un an plus tard, et rencontre un succès tel qu’elle représente presque aussitôt l’essentiel du trafic 36.

En revanche, l’invention du World Wide Web (www) est bien plus récente. Elle résulte de l’intervention du protocole Hypertext Markup Language (HTML) par le Britannique Tim Berners-Lee 37. Le HTML a permis d’agencer des informations telles que du texte, mais aussi des images, des vidéos, des sons, sous la forme de « pages Web ». C’est également ce protocole qui permet de relier des éléments d’une page à la fois entre eux (par le biais d’un lien hypertexte interne) et à des ressources tierces (par l’intermédiaire d’un lien hypertexte externe). Ce protocole a longtemps été mis en œuvre de manière exclusive par des logiciels généralistes, les navigateurs, mais il est aujourd’hui largement employé par des programmes spécialisés, les applications, en particulier sur les téléphones intelligents. Ainsi, « le Web » représente un usage particulier « d’Internet », à strictement raisonner.

Toutefois, il est très courant d’utiliser le mot « Internet » comme un raccourci pour désigner des usages du réseau, et les développements qui suivront ne se priveront pas d’utiliser ainsi le terme lorsque cela ne présentera aucun danger particulier de confusion sur le plan technique.

Ainsi s’achève une première présentation, rudimentaire, des progrès que l’on peut regrouper sous le concept de « technologies numériques ». Des compléments ou approfondissements seront proposés au fil de l’étude, en tant que de besoin.

Il est temps de proposer une première description des relations qu’entretient le monde du numérique avec celui du droit (II).